Negli ultimi anni l’intelligenza artificiale (IA) ha trovato una collocazione sempre più stabile all’interno dell’agenda dell’Unione europea. Tuttavia, dalla mole di atti e documenti di istituzioni e organi UE in materia affiorano i tipici problemi che affliggono le prospettive di regolamentazione dell’IA. In estrema sintesi, l’IA è ad oggi uno dei drivers principali del mercato unico digitale dell’Unione ed avrà un ruolo strategico nel corso del “decennio digitale europeo”, sebbene sia noto il potenziale nocivo del suo impatto su molti diritti fondamentali (v. inter alia FRA).

Alla luce di ciò, acquista particolare rilievo la proposta di regolamento UE sull’IA che la Commissione europea ha pubblicato il 21 aprile 2021. La proposta fa seguito a un draft circolato la settimana precedente e rappresenta il primo vero tentativo di regolamentare l’IA in ambito europeo (e non solo, v. Garante europeo per la protezione dei dati). Ha ad oggetto l’immissione sul mercato, la messa in servizio o l’uso di sistemi di IA in rapporti essenzialmente “business-to-business” e segue un approccio “basato sul rischio”.

Almeno in linea teorica, l’AIA esibisce una chiara dimensione antropocentrica, muovendo dagli orientamenti etici elaborati dal Gruppo di esperti ad alto livello sull’IA nel 2019. Pur nascendo come strumento di armonizzazione ai fini del mercato interno, l’AIA è stato costruito in modo da risultare fortemente improntato alla tutela dei diritti fondamentali. Scorrendo il testo della proposta si nota che i richiami alla Carta dei diritti fondamentali e a specifiche fattispecie da essa enunciate sono numerosissimi e “visibili”, in linea con gli auspici della nuova Strategia UE per il rafforzamento dell’applicazione della Carta medesima. Dunque, il regolamento immaginato dalla Commissione accentuerebbe il perdurante processo di penetrazione dei diritti fondamentali nel mercato interno.

Per giunta, la proposta tocca il tema della tutela dei diritti fondamentali in maniera pressoché trasversale. L’intento della Commissione sembra infatti essere quello di offrire protezione contro pregiudizi che minacciano molti diritti fondamentali “esposti” agli effetti dei sistemi di IA. Questo nonostante la presenza, in qualità di basi giuridiche, dell’art. 114 TFUE, concernente il buon funzionamento del mercato interno, e dell’art. 16 TFUE, relativo alla sola tutela dei dati personali e legato a doppio filo all’art. 8 della Carta dei diritti fondamentali.

Non sorprende, allora, che il primo degli obiettivi specifici elencati nella relazione che introduce l’AIA sia “assicurare che i sistemi di IA immessi sul mercato dell’Unione e utilizzati siano sicuri e rispettino la normativa vigente in materia di diritti fondamentali e i valori dell’Unione”. Anzi, forse è proprio il riferimento ai valori fondanti dell’Unione l’aspetto di maggiore interesse della proposta, almeno nei termini in cui la si sta considerando. In pratica, e sulla scia del Libro bianco sull’IA di febbraio 2020, un tratto distintivo dell’AIA è il suo allacciamento rafforzato alla “dimensione costituzionale” dell’UE, vista l’accessorietà dello strumento alla salvaguardia dell’intero impianto assiologico sovranazionale ex art. 2 TUE. Perciò, prima che sul piano giuridico e tecnologico, l’AIA “si caratterizza per una forte base culturale e valoriale” (De Gregorio e Pollicino).

A tale proposito, è opportuno precisare che negli atti legislativi affini all’AIA – in specie, molti di quelli adottati per affermare il mercato unico digitale – non è comune rinvenire accenni così espliciti e diffusi ai valori UE. Ad esempio, è risaputo che il Regolamento (UE) 2016/679 (GDPR), fondato esclusivamente sull’art. 16 TFUE, è stato realizzato con l’obiettivo di coniugare dimensione mercantilistica e concezione personalistica dei dati personali; nondimeno, esso non propone spunti paragonabili all’AIA sul rapporto tra diritto derivato e valori UE. Considerazioni analoghe valgono per la recente proposta di “legge sui servizi digitali”, che rappresenterebbe pur sempre il frutto di una scelta “identitaria”, cioè volta a “delineare, in maniera ancora più netta, l’identità – dal punto di vista non solo giuridico ma, in senso più lato, assiologico – dell’Unione europea” (Resta). Pertanto, attraverso l’AIA si registra indubbiamente a un’evoluzione della “narrativa” dei valori fondanti dell’Unione nel diritto derivato.

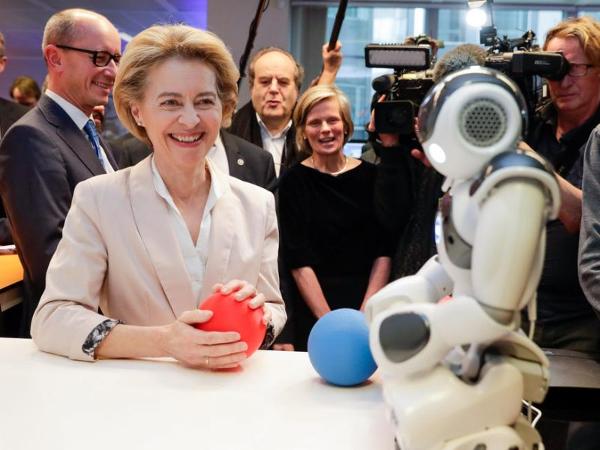

Tra l’altro, considerate anche le ambizioni dell’Unione di estensione territoriale del proprio sistema di tutela di diritti fondamentali in ambito digitale (a questo proposito sono celebri le sentenze Schrems I e Scrhems II della Corte di giustizia), un’iniziativa come quella in commento è funzionale all’affermazione della “sovranità digitale europea”, che a sua volta, e pur tra varie incertezze di fondo, pone l’Unione di fronte a una “battaglia da vincere” (Floridi) salvaguardando le proprie regole e i propri valori in tutto il mondo (così Ursula von der Leyen, riferendosi al concetto di “tech sovereignty”).

In virtù di questi presupposti, ecco che con l’AIA si ha la concretizzazione dei diritti fondamentali e, soprattutto, dei valori come canoni supremi (se non esclusivi) per la formulazione di restrizioni e di divieti. Sono i diritti fondamentali e i valori i parametri di riferimento alla radice di quell’approccio basato sul rischio che di fatto anima la proposta.

Circa il primo punto, nell’AIA vengono indicati all’interno di un elenco chiuso i sistemi di IA “ad alto rischio”, i quali sono legittimi solo laddove siano osservati diversi obblighi dettati dalla proposta. Ciò, in ultima analisi, perché i sistemi di IA rientranti in questa categoria sono considerati potenzialmente pericolosi per la salute e la sicurezza o, più in generale, per i diritti fondamentali delle persone fisiche; ma nella proposta si dichiara altresì che “(g)li utenti di IA dovrebbero beneficiare della certezza del diritto in merito al fatto che i sistemi di IA ad alto rischio che essi acquistano rispettano le normative e i valori europei”.

Quanto poi ai divieti operativi, la Commissione intende proibire – ma fatte salve eccezioni consistenti – alcune pratiche di IA (art. 5 AIA): le tecniche subliminali messe in atto per alterare significativamente il comportamento di una persona in modo dannoso; quelle che permetterebbero alle autorità pubbliche di ottenere il cosiddetto “punteggio sociale” degli individui; i sistemi di identificazione biometrica attivati a distanza, in tempo reale e in spazi accessibili al pubblico allo scopo di attuare la legge. Ebbene, nella proposta si spiega che queste pratiche non sono consentite perché presuppongono un rischio “inaccettabile in quanto contrario ai valori dell’Unione”.

Malgrado quanto appena visto, però, vi è da dire che già a un primo sguardo si ha la sensazione che, proprio per come sono state redatte alcune disposizioni chiave della proposta, è verosimile che la portata degli elementi di novità di cui sopra all’atto pratico tenderà a evaporare.

Al di là di analisi più approfondite in argomento (es. Krupiy), sembra proprio che, come lamentato dal Comitato e dal Garante europeo per la protezione dei dati in una recente opinione congiunta, la lista di divieti sia eccessivamente ristretta e circostanziata. Addirittura, l’art. 5 AIA è più “indulgente” rispetto al suo corrispettivo nel draft circolato poco prima che la proposta fosse pubblicata. Ne deriva che i limiti alle pratiche foriere di rischi inaccettabili ben potrebbero essere aggirati in varie ipotesi (v. anche EDRI).

Analogamente, una lista predefinita e tassativa, ma al contempo vaga, di sistemi di AI ad alto rischio non pare essere una scelta ottimale per raggiungere l’obiettivo di tutela dei diritti fondamentali, in considerazione dell’evoluzione rapida e costante della tecnologia. E al tempo stesso, la formula “rischio per i diritti fondamentali”, alla base della qualificazione aprioristica dei sistemi di IA ad alto rischio, non aiuta più di tanto, perché troppo generica. Senza, infine, dimenticare, che l’estensione della proposta ai soli rapporti tra professionisti incide non poco sui diritti dei soggetti più vulnerabili al cospetto dell’IA.

Questi (e moltissimi altri) aspetti saranno sicuramente considerati nelle fasi che contraddistingueranno la procedura di adozione di un atto suscettibile di determinare intense ricadute in un contesto segnato da vuoti normativi multilivello, al punto che si è parlato di “EU Law brutality” (Papakonstantinou e De Hert). Una procedura che quindi si annuncia alquanto lunga ed estremamente dibattuta e che fornirà innumerevoli spunti di discussione agli studiosi del diritto.

Intelligenza artificiale nel regolamento UE